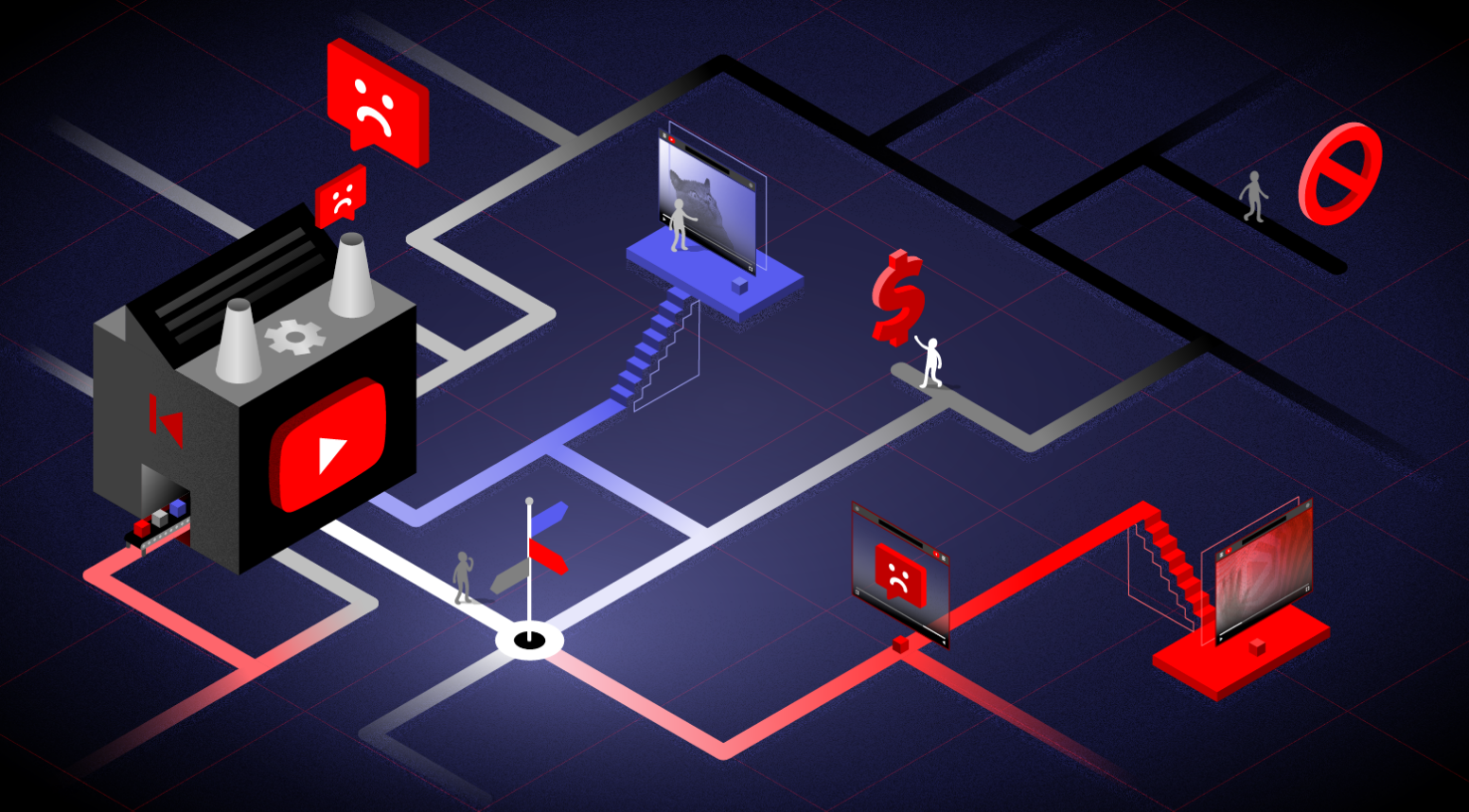

Die Recherchen, die anhand von Daten durchgeführt wurden, die uns tausende YouTube-Nutzer*innen bereitgestellt haben, haben offengelegt, dass YouTubes Algorithmus Videos mit Fehlinformationen, gewalttätigen und betrügerischen Inhalten und Hasstiraden empfiehlt.

Außerdem sieht es Recherchen zufolge so aus, als würden Nutzer*innen in nicht-englischsprachigen Ländern viel wahrscheinlicher auf verstörende Videos stoßen.

(7.Juli 2021) – Eine heute veröffentlichte zehnmonatige Untersuchung von Mozilla, die durch Crowdsourcing unterstützt wurde zeigt, dass YouTubes kontroverser Algorithmus Videos empfiehlt, deren Inhalte verstörend sind, Hassnachrichten enthalten und gegen die Richtlinien der Plattform verstoßen. Der tiefgründigen Recherche zufolge sieht es so aus, als würden Nutzer*innen in nicht-englischsprachigen Ländern viel wahrscheinlicher auf Videos stoßen, die sie als verstörend einstufen würden.

Mozilla führte die Recherche mithilfe der Open-Source-Browsererweiterung RegretsReporter durch, die tausende YouTube-Nutzer*innen in YouTube-Schnüffler*innen verwandelte. Dabei spendeten die Nutzer*innen ihre Daten freiwillig und ermöglichten den Forscher*innen Zugriff auf eine große Menge an Empfehlungsdaten von YouTube, die von der Plattform normalerweise nicht so offenherzig geteilt werden. Die Untersuchung ist die bisher größte durch Crowdsourcing ermöglichte Recherche des YouTube-Algorithmus.

Zu den Highlights der Untersuchung zählen:

- Freiwillige Helfer*innen stießen bei ihrer Recherche auf eine Reihe unerfreulicher Videos. Berichtet wurde über Videos, die im Hinblick auf COVID-19 Angst schüren, Videos mit Fehlinformationen über Politik und höchst unangemessene „Kinder“-Cartoons.

- Am stärksten betroffen sind Nutzer*innen aus nicht-englischsprachigen Regionen. Dabei ist der Anteil an unerfreulichen Videos um 60 % höher als in Ländern, in denen Englisch die Primärsprache ist.

- Ganze 71 % der Videos, die von freiwilligen Helfer*innen als unerfreulich kategorisierten, wurden aktiv durch den YouTube-Algorithmus empfohlen.

- Fast 200 vom YouTube-Algorithmus an unsere freiwilligen Helfer*innen empfohlene Videos wurden von YouTube mittlerweile entfernt – darunter verstoßen mehrere gegen YouTubes eigene Richtlinien. Diese Videos wurden insgesamt 160 Millionen Mal angesehen, bevor sie entfernt wurden.

„YouTube muss eingestehen, dass der Algorithmus der Plattform so funktioniert, dass er Menschen schadet und Fehlinformationen verbreitet.“

Brandi Geurkink, Mozillas Senior Manager of Advocacy

„YouTube muss eingestehen, dass der Algorithmus der Plattform so funktioniert, dass er Menschen schadet und Fehlinformationen verbreitet“, sagt Brandi Geurkink, Mozillas Senior Manager of Advocacy. „Unsere Recherchen haben ergeben, dass YouTube nicht nur Videos eine Plattform bietet, die gegen YouTubes eigene Richtlinien verstoßen, sondern diese auch noch aktiv empfiehlt. Außerdem wissen wir, dass Menschen in nicht-englischsprachigen Ländern am wahrscheinlichsten von YouTubes außer Kontrolle geratenem Empfehlungs-Algorithmus betroffen sind.“

„Wir bei Mozilla hoffen, dass diese Ergebnisse – die ja nur die Spitze des Eisbergs sind –, die Öffentlichkeit und Gesetzgeber davon überzeugen werden, dass im Hinblick auf YouTubes KI dringend mehr Transparenz nötig ist“, so Geurkink weiter.

Während der Studie erhobene Daten verbildlichen, wie YouTubes Algorithmus schädliche, widerlegte und unangemessene Inhalte verbreitet: Eine Person sah sich Videos über das US-Militär an und erhielt dann eine Empfehlung, ein frauenfeindliches Video mit dem Titel „Man humiliates feminist in viral video“ (deutsch: Mann erniedrigt Feminist:in in viralem Video) anzusehen. Eine andere Person schaute sich ein Video zum Thema Softwarerechte an und erhielt dann einen Vorschlag für ein Video über Waffenrechte. Eine dritte Person schaute sich ein Musikvideo von Art Garfunkel an und erhielt anschließend eine Empfehlung, sich ein Video mit dem Titel „Trump Debate Moderator EXPOSED as having Deep Democrat Ties, Media Bias Reaches BREAKING Point“ anzusehen (deutsch: Moderator bei Trump Debatte ENTHÜLLT, tief demokratisch verwurzelt zu sein, Voreingenommenheit der Medien erreicht SIEDEpunkt“).

Obwohl die Recherchen eine Vielzahl an Beispielen von Hasstiraden, widerlegten politischen und wissenschaftlichen Fehlinformationen und anderen Kategorien aufdeckte, die wahrscheinlich gegen YouTubes Community-Richtlinien verstoßen würden, hat sie auch viele Beispiele offengelegt, die zeigen, wie kompliziert das Thema Online-Risiken ist. Viele der gemeldeten Videos können der Kategorie „Grenzwertige Inhalte" zugeteilt werden – Videos, die fast gegen YouTubes Richtlinien verstoßen, aber eben nur fast.

Zu den Highlights des Berichts zählen:

Der Algorithmus ist das Problem

- Die Wahrscheinlichkeit, dass Nutzer*innen die Ansicht eines empfohlenen Videos bereuen ist um 40 % höher, als bei Videos, nach denen sie gesucht haben.

- Mehrere von YouTube empfohlene Videos, die Nutzer*innen im Nachhinein lieber nicht gesehen hätten, wurden später aufgrund von Verstößen gegen die Community-Richtlinien der Plattform entfernt. Etwa 9 % dieser empfohlenen Videos wurden seitdem von YouTube entfernt, allerdings erst, nachdem sie zusammengenommen bereits 160 Millionen Ansichten generiert hatten.

- Aus den Daten, die Mozilla von freiwilligen Helfer*innen erhalten hat, geht hervor, dass in 43,6 % aller Fälle, in denen die Ansicht eines Videos im Nachhinein bereut wurde, die Empfehlung absolut nichts mit den Inhalten/Videos zu tun hatte, die der/die Nutzer:in vorher angeschaut hatte.

- Dabei erzielen solche Videos auf YouTube besonders gute Ergebnisse: Gemeldete Videos erreichen bis zu 70 % mehr Ansichten pro Tag als andere Videos, die freiwillige Helfer*innen ansahen.

Nicht alle Menschen sind vor YouTubes Algorithmus gleich

- Die Anzahl an Videos, die sich Nutzer*innen im Nachhinein lieber nicht angesehen hätten, liegt in Ländern, in denen Englisch nicht die Primärsprache ist, um 60 % höher.

- Besonders viele Meldungen gibt es in nicht-englischsprachigen Ländern zu pandemiebezogenen Inhalten. In englischsprachigen Ländern sind 14 % aller Meldungen pandemiebezogen. In nicht-englischsprachigen sind es 36 %.

Forscher*innen von Mozilla empfehlen Gesetzgebern und Plattformen eine Reihe an Lösungswegen, um dieses Problem anzugehen. Dazu Brandi Geurkink: „Mozilla hat es sich nicht nur zum Ziel gesetzt, das Problem mit YouTube-Empfehlungen zu diagnostizieren – wir möchten es lösen. Vernünftige Gesetze bezüglich Transparenz, eine verbesserte Überwachung und Druck durch die Verbraucher können dabei helfen, den Algorithmus zu zügeln.“

Die Untersuchung empfiehlt folgende Maßnahmen:

- Plattformen sollten regelmäßig gründliche Transparenzberichte veröffentlichen, die Informationen über die Algorithmen für Empfehlungen enthalten

- Plattformen sollten es Nutzer*innen ermöglichen, personalisierte Empfehlungen abzuschalten

- Plattformen sollten Risikomanagementsysteme entwickelt, die sich ausschließlich mit dem Empfehlungs-Algorithmus beschäftigen

- Gesetzgeber sollten Gesetze verabschieden, die Transparenz bei KI-Systemen vorschreiben und unabhängige Forscher*innen schützen

~

Zur Methodologie: Mozilla hat für die Durchführung dieser Untersuchung rigorose quantitative und qualitative Methoden angewandt. Zu den statistischen Methoden gehören die Berechnung von Anzahlen, Proportionen und Werten, wobei nach relevanten Variablen unterschieden wurde. Alle in diesem Bericht beschriebenen Unterschiede waren statistisch auf einem Niveau von p < 0,05 relevant. Sämtliche statistische Relevanz wurde auf diesem Niveau bewertet. Mozilla beauftragte außerdem eine Arbeitsgruppe bestehend aus Experten in den Bereichen Online-Risiken, Meinungsfreiheit und Tech-Richtlinien damit, eine Auswahl gemeldeter Videos anzusehen und ein konzeptuelles Rahmenwerk zu entwickeln, diese Videos in Bezug auf YouTubes Community-Richtlinien einzuordnen. Ein Team aus 41 wissenschaftlichen Mitarbeiter*innen der University of Exeter nutzten dieses konzeptuelle Rahmenwerk dann dazu, die gemeldeten Videos zu beurteilen. Mehr dazu erfahren Sie im Abschnitt „Methodologie“ des Berichts.

Über diese Arbeit: Jahrelang hat YouTube Fehlinformationen im Bereich Gesundheit, politische Desinformationen, Hasstiraden und andere bedauerliche Inhalte empfohlen. Untersuchungen von Mozilla, der Anti-Defamation League, der New York Times, der Washington Post, des Wall Street Journal und einiger weiterer Organisationen und Verlage haben offengelegt, wie diese Empfehlungen Menschen polarisieren, radikalisieren und Fehlinformationen vermitteln. Leider hat YouTube auf die geäußerte Kritik bisher nur mit Untätigkeit und Undurchsichtigkeit reagiert. Gefährliche Empfehlungen bestehen auf der Plattform fort, und Dritte, die sich der Überwachung YouTubes verschrieben haben, sind weiterhin darüber im Unklaren, wie schwerwiegend sie sind oder wie regelmäßig sie auftauchen.

Als Teil unseres Einsatzes für vertrauenswürdige KI bitten wir YouTube schon seit Jahren, das Problem anzugehen. Wir haben anderen, die dieses Thema untersuchen, Stipendien und Preise angeboten, die schlimmsten Erfahrungen von Nutzer*innen gesammelt, konkrete Empfehlungen an YouTube ausgesprochen, öffentliche Diskussionen ausgerichtet und mehr.